Alfonso Casani – FUNCI

El periódico La Vanguardia recogía recientemente los resultados de un experimento que tenía por objetivo medir las posibilidades de la inteligencia artificial de emitir juicios morales, y que había terminado por emitir juicios de carácter racista y misóginos. El experimento constituye un caso paradigmático que pone en evidencia el problema de la condicionalidad de los conocimientos sobre los que se apoya la inteligencia artificial. Si nosotros somos racistas, también lo serán nuestras máquinas.

En términos simples, la inteligencia artificial se refiere a la capacidad de aprendizaje y desarrollo de las máquinas y sus procesadores, con el objetivo de aprender del conocimiento y las bases de datos proporcionados, y emitir respuestas autónomas que sean capaces de adaptarse al entorno. Como explica el propio Parlamento Europeo, el objetivo es que las máquinas sean capaces de emitir razonamientos, aprender, crear y planear sus acciones.

El experimento recogido por el periódico español analizaba las respuestas de un ordenador ante distintas situaciones y comportamientos, sobre la base del conocimiento adquirido por éste en las redes y foros virtuales. Para sorpresa de los científicos involucrados, las respuestas ofrecidas por la máquina reflejaban un comportamiento de carácter racista (mayor sospecha de la población negra que de la caucásica, por ejemplo) y machista (por ejemplo, considerando correcto besar a una mujer aunque esta haya expresado su rechazo).

VIDEOANÁLISIS | HAL 9000 ha resultado ser nazi

«Un experimento sobre el aprendizaje moral de la inteligencia artificial fracasa tras comprobar que la máquina se convirtió en racista y machista: la gran metáfora de la democracia digital», explica @pvallinhttps://t.co/9CWlrEdcKI pic.twitter.com/SPOAzQNaNU

— La Vanguardia (@LaVanguardia) November 19, 2021

El experimento subraya uno de los grandes problemas de la inteligencia artificial. Su sistema necesita apoyarse sobre bases de datos recopilados por el ser humano, que, implícitamente, transmiten muchos los juicios (y prejuicios) de sus diseñadores. Como concluye la noticia de La Vanguardia, en este caso, la máquina no hace sino ofrecer “un condensado de lo que somos en nuestro comportamiento en tanto sociedad digital”.

Diseñadores blancos y productos racistas

El ejemplo mencionado no es sino el último de una larga lista de productos e investigaciones que han mostrado los riesgos de transmisión de patrones de discriminación a las máquinas o programas desarrollados. Por un lado, aquellos programas basados en datos o informes pueden contribuir a repetir un mismo comportamiento.

En el año 2016, distintos investigadores denunciaron la tendencia discriminatoria del programa “Correctional Offender Management Profiling for Alternative Sanctions” (Compas), un programa de evaluación de riesgo de reincidencia delictiva, hacia la comunidad negra estadounidense. El programa, según se denunció, tenía el doble de posibilidades de considerar a una persona de color como posible reincidente que a una persona blanca. Aunque se desconocen los cálculos específicos que subyacen al programa, éste refleja un problema de base, al apoyarse sobre las estadísticas históricas de población en prisión en Estados Unidos, entre las cuales la población negra ocupa un porcentaje mayor.

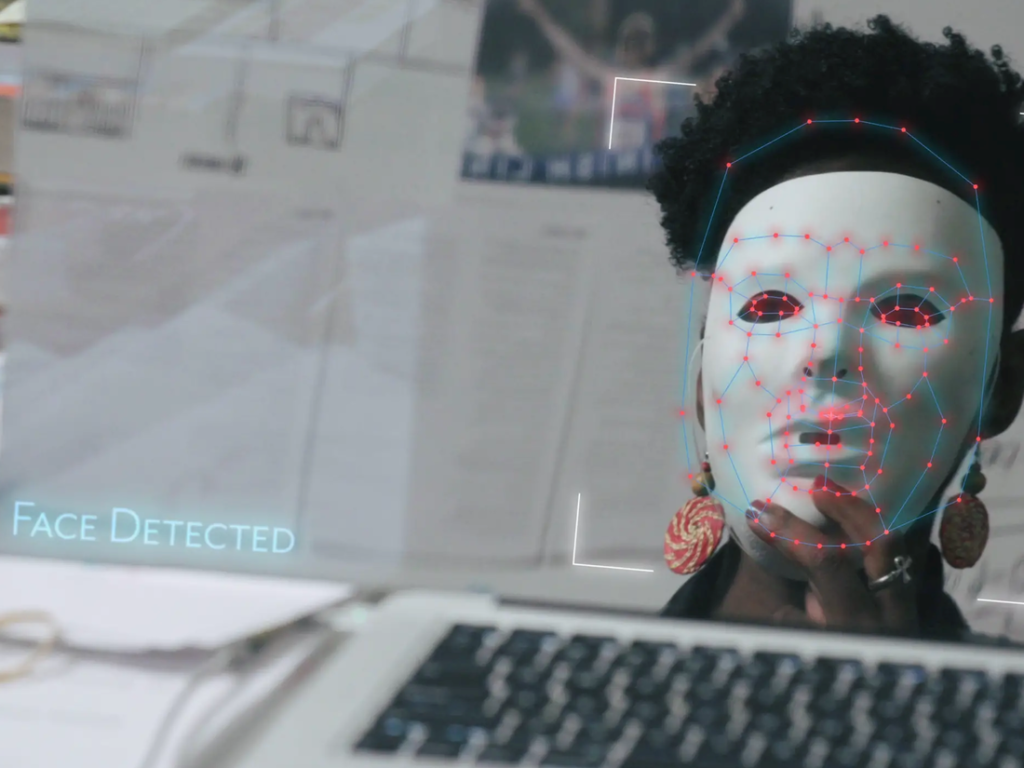

Igualmente chocantes son las múltiples denuncias contra las máquinas de reconocimiento facial realizadas en los últimos años. Es notable, y ampliamente conocido, el sesgo mostrado por la aplicación Google Photos, cuya modalidad de clasificación de las personas u objetos confundía a la población negra con gorilas, como se denunció en el año 2015.

En esa misma línea, una estudiante del renombrado MIT (Instituto Tecnológico de Massachusets), Joy Buolamwini, denunció ese mismo año los problemas que los programas de reconocimiento facial para reconocer las caras de la población negra. Buolamwini, como persona negra, comprobó que estos programas tenían dificultades para identificar sus rasgos faciales, mientras que si se ponía una máscara blanca, sus rasgos era identificados sin dificultad. El problema se acrecentaba cuando se trataba de mujeres, frente a hombres. Su estudio fue aplicado a los sistemas de inteligencia artificial de los principales gigantes tecnológicos, Amazon, IMB y Microsoft. De media, los tres mostraban un margen de error inferior al 1% cuando los rostros analizados pertenecían a varones blancos; sin embargo, el margen aumentaba hasta el 35% cuando se analizaban las caras de mujeres negras. Este caso nos conduce, de nuevo, a las bases de datos utilizadas, en el que la población negra y las mujeres se encuentran infrarrepresentadas, es decir, estas están construidas, sobre todo, sobre fotografías y datos de hombres blancos para ayudar a las máquinas a identificar los rasgos analizados.

Bajo este hecho subyace un segundo problema, que nos permite entender el surgimiento de este sesgo, diez de las mayores empresas tecnológicas de Silicon Valley no tienen ninguna empleada, mujer, negra. Tres de ellas no tenían, si quiera, ningún empleado de color. De manera subconsciente, los diseñadores de estos sistemas reproducen el entorno al que están acostumbrados, favoreciendo la representación de la población blanca y varón, frente a la de otras minorías.

Un caso similar se hizo viral hace varios años, cuando una máquina expendedora de jabón no lograba reconocer la mano de una persona negra, frente a la de su compañero blanco.

Un problema social

Estos ejemplos no pretenden negar las numerosas virtudes que presenta el desarrollo tecnológico y de la inteligencia artificial, sino reflexionar sobre la ausencia de neutralidad en el mismo, y el riesgo de reproducción de patrones discriminatorios que se esconden tras este hecho. El artículo menciona únicamente dos de los múltiples problemas a los que se enfrentan estos sistemas tecnológicos: la reproducción de la discriminación contra los colectivos minoritarios, y la reproducción de la falta de representación existente. Ambos son problemas sociales, y no tecnológicos, que muestran algunas de las faltas existentes en la sociedad. Es inevitable concluir que no son los sistemas informáticos los que deben corregirse, sino las propias sociedades.

Sin comentarios